使用唯一事件ID结合存储机制与业务状态判断实现去重,确保消息重复时不重复处理。

在微服务的事件驱动架构中,消息重复是,尤其在网络抖动、消费者超时重试或消息中间件故障时。去重的核心目标是确保同一业务事件即使被多次投递,也只被处理一次。实现方式需结合唯一标识、存储机制与幂等设计。

使用事件唯一ID进行去重

每个事件在生产时应携带一个全局唯一ID(如UUID),该ID由生产者生成并随事件一起发送。消费者在处理前先检查该ID是否已处理过。

- 事件结构中包含eventId字段,保证跨服务可识别

- 消费者接收到事件后,先查询本地去重表或缓存(如Redis)确认该ID是否存在

- 若存在则跳过处理,否则执行业务逻辑并记录该ID

基于数据库的幂等表或状态机

将事件ID与处理状态持久化到数据库,形成“幂等表”,适用于强一致性场景。

要想效果好,就用降重鸟。AI改写智能降低AIGC率和重复率。

113

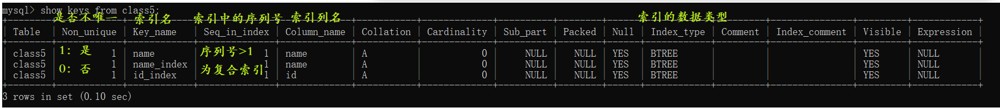

- 创建一张event_processing_log表,包含eventId、serviceName、status、createTime等字段

- 消费时通过唯一索引(eventId + service)防止重复插入

- 利用数据库的约束(如唯一键)自动拦截重复请求,避免并发问题

利用Redis实现高性能去重

对高吞吐场景,可用Redis的SET命令配合过期时间实现轻量级去重。

- 使用

SET event_id "1" EX 86400 NX命令写入事件ID,NX保证仅首次成功 - 若命令返回OK,则继续处理;若为NULL,则说明已处理过

- 注意设置合理的TTL,覆盖最大可能的重发窗口

结合业务状态做逻辑判断

去重不仅依赖技术手段,还需结合业务上下文判断是否应再次处理。

- 例如订单支付事件,先查订单当前状态是否已是“已支付”

- 如果是,则直接ACK消息,无需重复操作

- 这种方式天然具备幂等性,减少对外部去重存储的依赖

基本上就这些。关键是在事件源头生成唯一ID,并在消费端通过存储机制或业务逻辑拦截重复。系统设计时应默认消息可能重复,把去重和幂等作为基础能力来构建。