批量操作能显著提升性能,1. 通过减少网络往返次数,将多条操作打包成一次请求;2. 降低sql解析与优化开销,避免重复生成执行计划;3. 提高磁盘i/o效率,利用顺序写入减少随机寻道;4. 最小化事务开销,批量操作在单个事务中提交,减少日志刷盘频率;5. 使用多值insert、load data infile、insert into … select实现高效批量插入,并结合insert ignore或on duplicate key update处理重复数据;6. 批量update推荐采用case when、多表join更新,并在应用层分批提交以避免锁争用;7. 注意事务大小平衡,避免长事务导致锁等待和binlog膨胀,同时确保where条件使用索引以提升执行效率,所有操作建议在事务中进行以保障数据一致性,最终通过合理批次大小测试找到性能最优解。

MySQL中执行批量数据操作,核心在于减少与数据库的交互次数,无论是插入还是更新,都尽可能一次性提交更多的数据。这不仅能大幅降低网络传输开销,还能让数据库内部的解析、优化和磁盘I/O更高效,从而显著提升整体性能。简单来说,就是把零散的活儿打包成一整块去干。

解决方案

要高效地在MySQL中进行批量数据操作,主要技巧体现在以下几个方面:

批量INSERT操作:

最基础也是最常用的方式是使用多值插入(Multiple-Row Insert)。将多条

VALUES

子句用逗号分隔,一次性插入多行数据。

INSERT INTO your_table (column1, column2, column3) VALUES

('value1_1', 'value1_2', 'value1_3'),

('value2_1', 'value2_2', 'value2_3'),

('value3_1', 'value3_2', 'value3_3');

对于极其庞大的数据集导入,

LOAD DATA INFILE

命令是无与伦比的选择。它直接从服务器本地文件系统读取数据,绕过了SQL解析层,效率极高。

LOAD DATA INFILE '/path/to/your/data.csv' INTO TABLE your_table FIELDS TERMINATED BY ',' ENCLOSED BY '"' LINES TERMINATED BY '\n' (column1, column2, column3);

当需要从一个表的数据复制或加工后插入到另一个表时,

INSERT INTO ... SELECT

语句非常有用。

INSERT INTO target_table (col1, col2) SELECT source_col1, source_col2 FROM source_table WHERE some_condition;

批量UPDATE操作:

用AI技术提高数据生产力,让美好事物更容易被发现

26

针对不同行但同一列需要不同更新值的情况,可以使用

CASE WHEN

语句。

UPDATE your_table

SET

column1 = CASE id

WHEN 1 THEN 'new_value_for_id_1'

WHEN 2 THEN 'new_value_for_id_2'

ELSE column1

END,

column2 = CASE id

WHEN 1 THEN 'another_value_for_id_1'

WHEN 2 THEN 'another_value_for_id_2'

ELSE column2

END

WHERE id IN (1, 2);

当更新操作依赖于另一个表的数据时,可以使用多表UPDATE。

UPDATE table1 t1 JOIN table2 t2 ON t1.id = t2.id SET t1.column_to_update = t2.source_column WHERE t1.some_condition;

在应用层面,也可以通过构建包含大量ID的

IN

子句,或者分批次提交

UPDATE

语句来模拟批量更新,尤其是在处理百万级数据时,一次性更新所有可能会导致锁等待或内存问题。

批量操作能显著提升MySQL性能?

说到性能,我个人觉得,数据库操作就像是跟一个有点“懒”但又极其“高效”的工人打交道。你给他一个任务,他需要先听懂(解析SQL),然后想好怎么干(查询优化),接着动手(执行),最后告诉你结果(返回)。如果每个小任务都这么来一遍,那光是沟通成本和准备时间就耗光了。批量操作的核心,就是把这些“沟通”和“准备”的时间摊薄。

具体来说:

- 减少网络往返(Round Trips): 每次SQL请求都需要客户端和服务器之间进行一次或多次网络通信。批量操作将多条逻辑操作打包成一个请求,显著减少了网络延迟的影响。想象一下,是发1000封信还是一封装了1000页内容的信?显然后者效率高。

- 降低SQL解析与优化开销: 数据库服务器接收到SQL语句后,需要解析语法,并生成执行计划。批量操作意味着服务器只需对一个大的SQL语句进行一次解析和优化,而不是对1000个独立的语句重复这个过程。这省下的CPU周期可不是小数目。

- 更高效的磁盘I/O: 批量写入或更新数据时,MySQL的存储引擎(如InnoDB)可以更好地利用其内部缓冲区和日志机制。它可能将多个小写入合并成一个大的物理写入操作,减少了随机I/O,转为更高效的顺序I/O,从而减少了磁盘寻道时间。

- 事务开销最小化: 通常,批量操作会包裹在一个事务中。这意味着只有在事务提交时,才需要刷新日志到磁盘(fsync),并释放锁。如果每条记录都单独一个事务,那事务的开启、提交和日志刷盘的开销会被放大无数倍。

批量INSERT的几种实用技巧与注意事项

我见过不少项目,在数据导入时因为没用批量操作,活生生把几十秒的活儿拖成了几小时,甚至跑崩。所以,掌握批量INSERT的技巧,真的能救命。

- 多值插入的优雅与限制:

INSERT INTO table (col1, col2) VALUES (...), (...);

这种方式是最常见也最推荐的。它简单直观,效率也很高。但这里有个坑,单条SQL语句的长度是有限制的,受

max_allowed_packet

参数影响。如果你的批量插入语句太长,比如一次性插入几十万行,就可能报错。所以,需要根据实际情况和服务器配置,将大批量数据拆分成多个较小的批次进行插入。

-

LOAD DATA INFILE

:巨量数据的终极武器:

当你的数据量达到百万、千万甚至上亿级别时,LOAD DATA INFILE

几乎是唯一明智的选择。它绕过SQL层,直接将文件内容解析并写入表,效率比任何SQL语句都高出几个数量级。但它也有前提:文件必须在MySQL服务器可访问的路径上,且用户需要有

FILE

权限。安全性和权限管理在这里显得尤为重要。

- 处理重复数据:

INSERT IGNORE

与

ON DUPLICATE KEY UPDATE

:

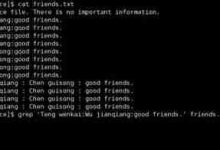

-

INSERT IGNORE INTO ...

:如果插入的数据会导致唯一索引或主键冲突,这条语句会忽略该行,不报错,继续处理其他行。这在导入可能包含重复数据但你只想保留第一份时很有用。

-

INSERT INTO ... ON DUPLICATE KEY UPDATE ...

:当插入的数据遇到唯一键冲突时,不插入新行,而是执行

UPDATE

操作。这在需要更新现有记录或插入新记录(“upsert”操作)时非常方便。

-

- 事务的运用: 无论你选择哪种批量插入方式,都强烈建议将其包裹在事务中。

START TRANSACTION; ... COMMIT;

。这样做的好处是,如果中间任何一步出错,你可以回滚整个批次的操作,保持数据的一致性。同时,这也减少了磁盘I/O,因为直到事务提交,数据才会被真正持久化到磁盘,减少了日志刷盘的次数。

- 批次大小的平衡: 究竟一次性插入多少条数据最合适?这没有固定答案,取决于你的服务器配置(CPU、内存)、网络带宽以及

max_allowed_packet

设置。通常,几百到几千行是一个比较安全的起点。太小的批次会增加网络和事务开销,太大的批次则可能触及

max_allowed_packet

限制,或者导致长时间的锁,影响其他操作。需要通过实际测试来找到最佳平衡点。

批量UPDATE的进阶策略与常见陷阱

批量更新,在我看来比批量插入更需要“智慧”,因为更新操作往往涉及数据的关联性,而且对锁的影响更大。

-

CASE WHEN

的灵活应用:

当你需要根据不同条件更新同一列的不同行,或者更新多列时,CASE WHEN

语句是首选。它让你的SQL语句保持简洁,并且在一次数据库交互中完成所有更新。这比写多条独立的

UPDATE

语句效率高得多。

- 多表JOIN更新: 当更新的数据源于另一个表时,使用

UPDATE ... JOIN ... SET ...

语法是标准做法。它能高效地将两个表关联起来,并根据关联结果进行更新。这在数据清洗、同步或基于业务逻辑进行批量调整时非常常见。

- 应用层面的分批处理: 很多时候,数据库中的数据量太大,一次性用

WHERE id IN (...)

更新所有相关记录可能导致SQL语句过长,或者锁定太多行,引发死锁或长时间阻塞。在这种情况下,更好的做法是在应用代码中分批次构建

UPDATE

语句。例如,每次处理1000或5000个ID,循环执行多次。这既能享受批量操作的优势,又能避免单次操作的风险。

- 对复制(Replication)的影响: 大规模的批量更新会产生大量的binlog(二进制日志)。如果你的MySQL是主从架构,这些binlog需要传输到从库并重放。一个巨大的更新事务可能导致从库延迟,甚至在从库上引发长时间的锁定。因此,在生产环境进行大规模批量更新前,务必评估其对复制链路的影响,并考虑在业务低峰期执行。

- 长事务的风险: 将一个巨大的批量更新包裹在一个事务中,虽然能保证原子性,但如果事务持续时间过长,它会持有大量的锁,阻止其他并发操作,并可能导致undo log(回滚日志)文件膨胀。这不仅影响数据库的并发性能,还可能耗尽磁盘空间。因此,在设计批量更新时,需要权衡事务的粒度,必要时进行分批提交。

- 索引的考量: 批量更新的

WHERE

子句是否使用了合适的索引,对性能至关重要。如果没有合适的索引,MySQL可能需要进行全表扫描,这会大大降低更新效率。在执行批量更新前,检查并确保相关列上存在有效索引。

- 避免过于复杂的

WHERE

子句:

尽管SQL很强大,但过于复杂的WHERE

子句,特别是包含大量

OR

条件或子查询的,可能会让优化器难以生成高效的执行计划。尽量保持

WHERE

子句的简洁和可索引性。

以上就是MySQL如何执行批量数据操作 基础INSERT/UPDATE批量处理技巧的详细内容,更多请关注php中文网其它相关文章!