rps 是 中用于软中断负载均衡的机制,通过软件分配网络包处理任务到多个 cpu。1. 它在网络软中断处理阶段平衡负载,避免单核瓶颈;2. 配置路径为 /sys/class/net/<interface>/queues/rx-<n>/rps_cpus,写入 cpu 掩码;3. 使用示例:echo 3 > /sys/class/net/eth0/queues/rx-0/rps_cpus 启用 cpu0 和 cpu1;4. 建议控制掩码范围、结合 rfs 使用、动态调整配置并注意 numa 架构影响。

设置 Linux 网络接口的 RPS(Receive Packet Steering)软中断负载均衡,主要是为了优化高流量场景下的网络性能。通过合理分配软中断处理 CPU,可以有效避免单核 CPU 成为瓶颈,提高系统整体吞吐量。

什么是 RPS?

RPS 是 Linux 内核中用于在网络软中断(softirq)处理阶段进行负载均衡的一种机制。它并不像 RSS 那样在硬件层面分发数据包,而是在软件层面将数据包的处理任务分配到多个 CPU 上,从而减轻单一 CPU 的压力。

简单来说,RPS 是在没有多队列网卡支持的情况下,实现类似效果的一个软件手段。

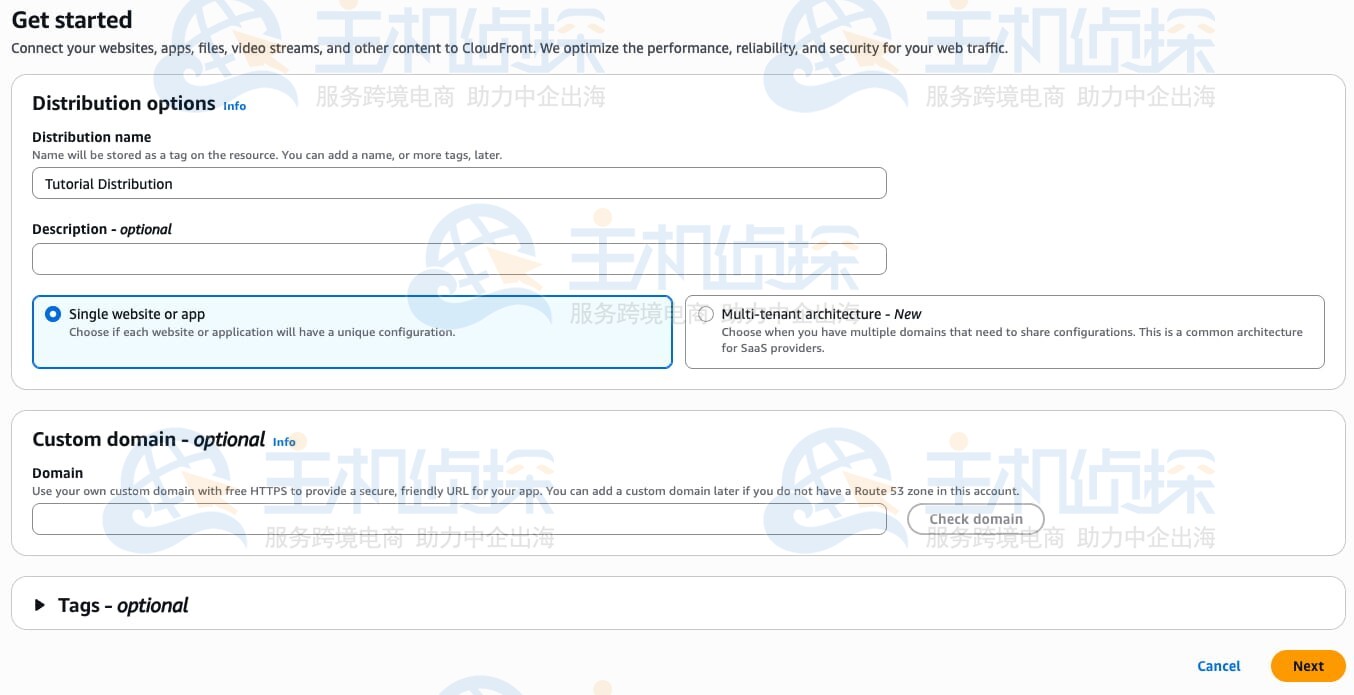

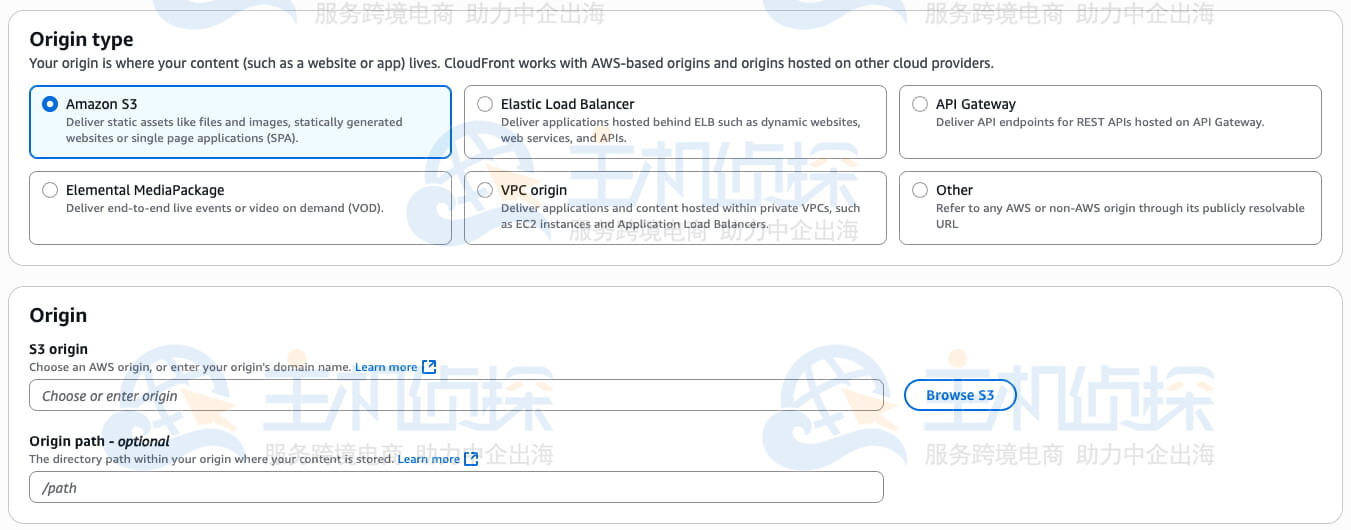

如何开启和配置 RPS?

要启用 RPS,需要对 /sys/class/net/<interface>/queues/rx-<n>/rps_cpus 文件进行配置,指定哪些 CPU 核心可以处理该队列的数据包。

操作步骤如下:

- 找到你要配置的网络接口,比如

eth0 - 查看其接收队列数量(通常为

rx-0,rx-1等) - 编辑对应队列目录下的

rps_cpus文件,写入目标 CPU 掩码

示例:

如果你想让 CPU0 和 CPU1 处理 eth0 的第一个接收队列的软中断:

这里的 3 是二进制 00000011,表示 CPU0 和 CPU1 被启用。

注意:CPU 掩码是按位表示的,比如 CPU0=1,CPU1=2,CPU0+CPU1=3,以此类推。

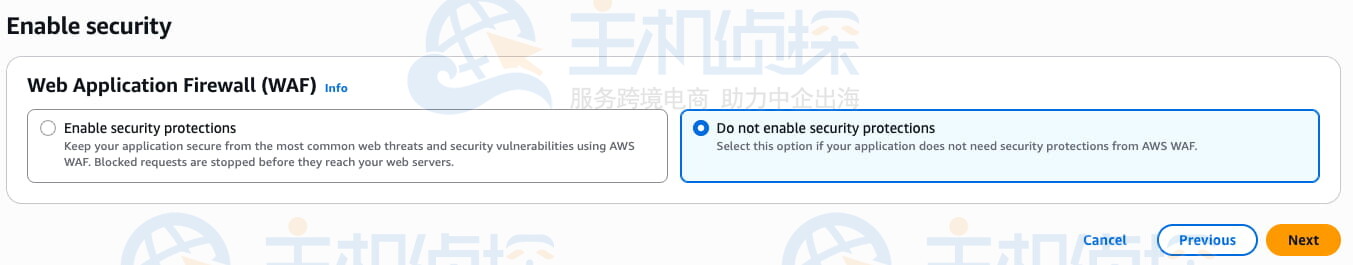

设置 RPS 的一些实用建议

- 掩码不要设得太广:虽然你可以把所有 CPU 都加进去,但跨 CPU 切换也有开销,适当控制范围更高效。

- 结合 RFS 使用更好:如果你的应用有较高的连接数或需要保持连接状态,可以同时启用 RFS(Receive Flow Steering),这样能更智能地绑定 CPU 与连接。

- 动态调整测试效果:不同业务负载下,CPU 分配策略可能不一样,可以在运行时修改

rps_cpus值观察性能变化。 - 注意 NUMA 架构影响:如果服务器是 NUMA 架构,尽量让 NIC 和 CPU 在同一个 NUMA 节点上,减少跨节点访问延迟。

配置文件位置一览

以下是一些常见路径,方便你查找和配置:

-

/sys/class/net/<iface>/queues/rx-<n>/rps_cpus—— 控制软中断处理 CPU -

eth00 —— 查看 softirq 在各 CPU 上的执行情况 -

eth01 —— 如果使用 RFS,可以设置流表大小

基本上就这些。只要理解了 RPS 是用来做什么的,以及如何设置对应的 CPU 掩码,剩下的就是根据实际业务需求灵活调整了。

以上就是如何设置Linux网络接口RPS 软中断负载均衡配置的详细内容,更多请关注php中文网其它相关文章!